Американские ученые из Мэрилендского университета (США) выяснили, что от маркировки созданных искусственным интеллектом картинок можно избавиться

Генераторы изображений на базе искусственного интеллекта все чаще применяются для создания изображений и видеороликов несуществующих событий, которые могут использоваться для намеренной дезинформации.

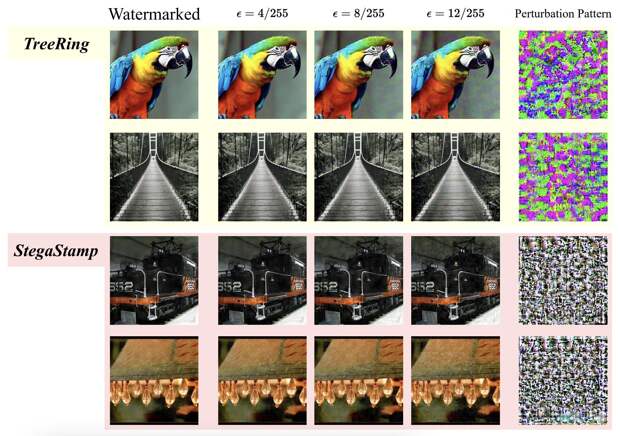

Власти разных стран предложили разработчикам внедрить маркировку подобного контента, и компании Alphabet, Amazon, Microsoft и OpenAI согласились это сделать, однако реализовать это на практике оказалось непросто.Создаваемые при генерации изображений водяные знаки можно удалить двумя разными способами. Диффузионная очистка позволяет уничтожать водяные знаки, размещенные на картинке с использованием методов с низким уровнем возмущений, таких как RivaGAN и WatermarkDM.

Для методов с высоким уровнем возмущений вроде StegaStamp применялась атака с подменой модели — она заставляет используемые для анализа ИИ системы идентифицировать сгенерированные изображения как «настоящие». Вероятно, теперь IT-гигантам придется искать новые способы маркировки.

Здесь мы рассказываем, как нейросети обрабатывают изображения:

University of Maryland

Свежие комментарии